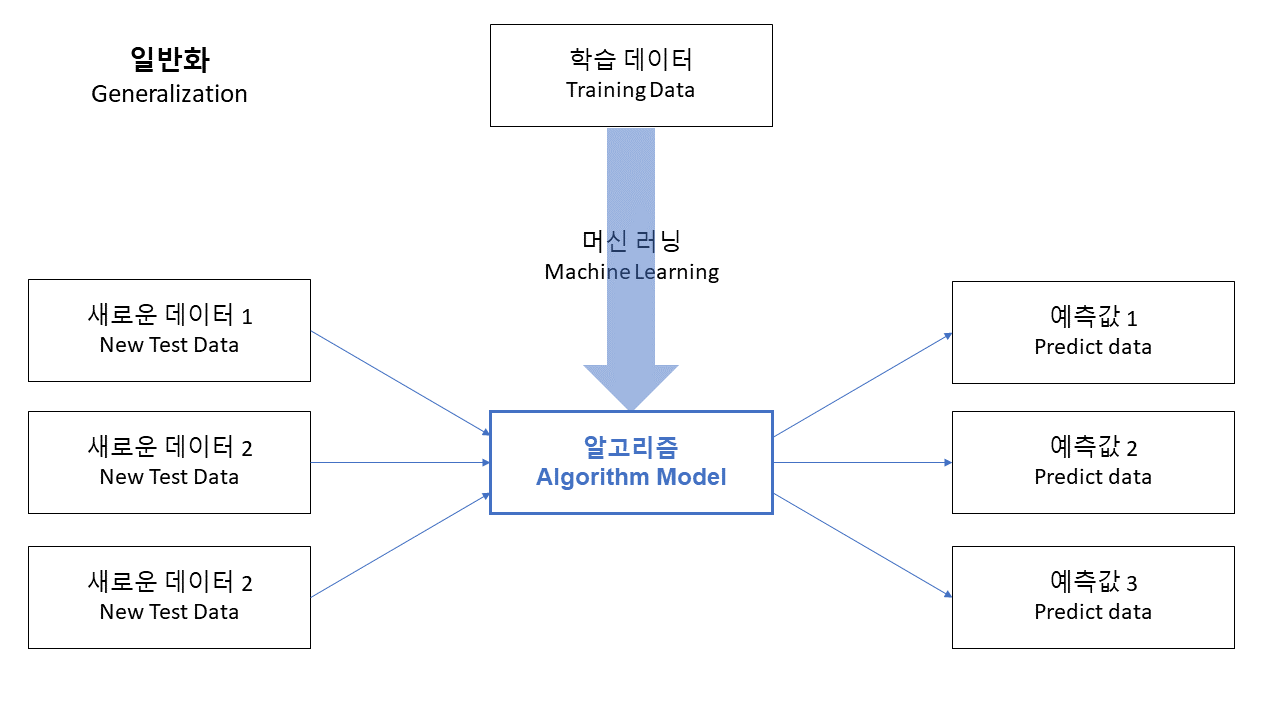

1. 머신러닝모델의 일반화

일반화 : 훈련데이터를 통해 학습해 만들어 낸 모델이, 다른 데이터셋들에 잘 맞아 들어가는 능력을 의미함

우리가 정말 관심있는것은 모델이 학습에 사용한 훈련(train) 데이터를 얼마나 잘 설명하는 모델이 아니라, 학습에 사용하지 않은 외부의 테스트(test) 데이터를 얼마나 잘 맞추는지이다.

2. 편향과 분산

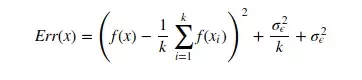

편향 : 오차(예측과 정답의 차이)의 크기, 예측이 정답에서 얼마나 벗어나 있는지 => 낮을 수록 좋다.

- 편향이 크다 : 모델과 테스트 데이터들 간에 오차가 크다.

분산 : 학습한 모델의 변동성, 예측값의 변동폭이 얼마나 큰지, 예측값들끼리의 차이 => 낮을 수록 좋다

- 분산이 크다 : 학습한 모델의 변동성이 크고 복잡해서, 각 테스트 데이터마다 오차의 값이 불규칙하게 나온다.

왼쪽 : 큰 평향, 낮은 분산

오른쪽 : 작은 편향, 큰 분산

3. 편향과 분산 트레이드 오프(Bias-Variance Trade-Off), 과적합(Overfitting)과 과소적합(Underfitting)

- 과적합(Overfitting) : 모델이 학습하는 값을 따라 복잡해질수록 편향(오차)은 작아지고, 분산이 커진다.

- 과소적합(Underfitting) : 모델이 단순해질수록 편향은 커지고, 분산은 줄어든다.

모델을 만들었을때 오차가 과적합 모델인지, 과소적합인지 파악한 후 이상적 모델을 만들기 위한 노력이 지속적으로 필요하다.

과적합 모델 -> 이상적 모델 예 ) Ridge Regression

반응형

'IT > AI-ML' 카테고리의 다른 글

| [YOLOv5]Colab Tutorial을 이용하여 학습 및 Inference시키기 1. (0) | 2022.08.20 |

|---|---|

| [Yolo] YOLO v5 튜토리얼 1.설치 (0) | 2022.08.03 |

| [AI-ML] 지도학습 vs 비지도학습 (0) | 2021.08.13 |

| 주성분분석(PCA: Principal component analysis) 개념 (0) | 2021.07.28 |

| Colab에서 Kaggle의 dataset 활용하기 (0) | 2021.07.27 |